移動ロボット,ヒューマノイドロボット,人工知能,ヒューマンロボットインタラクション,群知能ロボットシステム,自動化,最適化,生産システムなど

知能ロボット・システム工学(星野)研究室のホームページ

![]()

研究内容

ここでは,研究内容の詳細について,現在も継続中と一旦終了したものに別けて各テーマごとに掲載してあります.興味のあるテーマをクリックしてみてください.一旦休止しているテーマでも再開することは可能です.なお,企業との共同研究に関しては,研究成果が公開されてから記載させていただく予定です.

継続中の研究テーマ

無人航空機の自動操縦システム

深層学習に基づいた移動ロボットの動作計画法

パーソナルモビリティロボット

上体ヒューマノイドによる物体ハンドリング

NEDO先導研究プログラム/航空機向けの革新的検査技術開発/持続可能な航空機生産に関する研究開発

工場環境における無人搬送ロボットの推定された自己位置判定

一旦終了した研究テーマ

移動ロボットのロバストな自己位置推定

深層学習に基づいたロボットビジョンシステム

移動ロボットのモデルベースの経路・動作計画

移動ロボットによる知的な警備システム

葉緑体ロボット群のSwarm Intelligence

指のような機構の脚を有するロボットSHIKYAKU

小型滑空ロボットの開発と自律操舵制御

人間とロボットのインタラクション(相互作用)

人の動特性とロボットの混雑を考慮した人工ポテンシャル法

実際の人の動きを考慮した動特性ポテンシャルの生成

無人航空機の自動操縦システム(2020年~)

航空機の自動操縦において,着陸飛行は滑走路との物理的な接触が生じることから最も困難とされています.そこで,着陸飛行に焦点をあてた無人航空機のための自動操縦システムを開発しました.本自動操縦器は深層ニューラルネットワークにより構築され,計器情報よりもコックピット視点の画像情報を主な入力とし,ロール,ピッチ,ヨー,スロットルといった操舵制御出力を決定することで,航空機が無人で着陸飛行に成功しました.また,昼間だけでなく夜間での着陸飛行にも成功しています.以下に,学生による発表動画を掲載します.

深層学習に基づいた移動ロボットの動作計画法(2017年~)

移動ロボットによる障害物回避のための動作計画に関する研究に取り組んでいます.動作計画器には深層ニューラルネットワークが用いられ,センサ入力に対する所望の動作出力を人間が教示します.そして,これら入出力関係を模倣学習を通じて対応付けます.深層ニューラルネットワークとして,これまでは多層パーセプトロン(MLP: Multilayer Perceptron)や畳み込みニューラルネットワーク(CNN: Convolutional Neural Network)を適用してきましたが,今後は,Transformerの利用も考えています.以下に,研究発表の動画を掲載します.

パーソナルモビリティロボットのための操縦インタフェースと自己位置推定技術(2017年~)

一人乗りの次世代移動機器として,我々はパーソナルモビリティに注目しています.これまでに,栃木県庁ならびに県内有志企業と連携し,2台のパーソナルモビリティロボットを試作しました.栃木県庁でのお披露目を下野新聞様に取材していただきました.当研究室では,これらパーソナルモビリティロボットを活用したラスト1マイル問題の解決を目指しています.

パーソナルモビリティロボットを脳波で操縦するためのインタフェースBMI (Brain Machine Interface)の研究では,搭乗者の脳波を計測し,そこから移動と停止,直進,右折・左折といった操縦意図を推定し,その意図を制御指令へと変換することで,搭乗者の意図した通りにパーソナルモビリティを操縦することに成功しています.以下は,当研究室の7期生田上君が作成してくれた紹介動画となっています.

また,パーソナルモビリティはジョイスティックの操作でも運転することができます.しかし,限られた幅の歩道(車道)で障害物を避けながら運転は困難を極めます.そこで,搭乗者による運転に加え,モビリティにもカメラや3D LiDARといったセンサを搭載することで,両者の共有制御を通じた運転アシストシステムを開発しました.

パーソナルモビリティには,GPS,3D LiDAR,RGB-Dカメラ等が搭載され,これらを用いた自律移動の研究にも取り組んでいます.自律移動に向けては,事前にによる地図構築(SLAM: Simultaneous Localization and Mapping)を行うことが一般的です.モビリティの利用環境は多岐にわたり,全環境の地図化は困難です.そこで本研究では,国土地理院の基盤地図に着目しました.そして,基盤地図の測量データから生成された占有格子地図上での自己位置推定法ならびに自律移動技術を提案しています.動画では,ロボットが環境の占有格子地図とオンラインSLAMにより生成した地図上にて自己位置推定を行う様子がご覧になれます.

上体ヒューマノイドによる物体ハンドリング(2017年~)

上体ヒューマノイドは,両腕・両手の協調により,複雑な作業を行うことができます.我々はまず,ロボットに双腕の動作を教示し,それをロボットが再生するティーチングプレイバックシステムシステムを開発しました.このシステムにより,後に続く動作計画に向けた深層ニューラルネットワークの模倣学習(Imitation Learning)も可能となります.

さらに,物体をつかむために両手を近づけるリーチング動作計画や,つかんだ物体を棚に収納するための動作計画の研究に取り組んでいます.従来のマニピュレータによる動作計画では空間の3次元的な計測が必要とされていましたが,本研究ではロボットによる視覚的空間知覚に焦点をあて,カメラ画像を深層ニューラルネットワークへの入力とすることで,3次元計測が不要な動作計画に成功しています.

移動ロボットのロバストな自己位置推定(2019~2021年)

ロボットが自律的に移動するためには,地図上での自分の位置(・姿勢)を正確に把握できる必要があります.そのための技術を自己位置推定と言います.自己位置推定は,地図とセンサ情報に基づき行われるのですが,環境変化により,地図と現在の環境に齟齬が生じると,ロボットが自己位置を誤推定してしまう問題があります.そこで本研究では,パーティクルフィルタを用いた自己位置推定において,地図とセンサデータそれぞれの距離と分布に基づく観測モデルを提案し,これにより,環境変化にロバストな自己位置推定を達成しました.

自己位置推定に関する研究は,7期生の小林君の卒業とともに一度終了しましたが,その後,民間企業との共同研究として再開し,現在は自己位置推定の正しさについての判断や,環境変化の検出に関する研究に取り組んでいます.

深層学習に基づいたロボットビジョンシステム(2015~2020年)

ロボットにとって,周囲環境の計測および認識・識別は重要な技術となります.認識・識別に関しては,近年,深層学習(Deep Learning)が技術的なブレークスルーとして注目を集めています.そこで2015年より,ロボットのビジョンシステムに深層学習技術を適用した物体認識に関する研究に取り組んでいます.本研究では,人の動きをオプティカルフローで表現し,これをCNN(Convolutional Neural Network)に入力することで人物検出およびその動作の認識に成功しています.動画では,検出した人物の周囲に赤枠が表示され,認識された動作が出力されます.30 [fps]以上の処理速度で実時間性を達成しました.

さらにこの物体認識技術を,移動ロボットに適用しています.しかしながら,移動するロボットに搭載されたカメラ画像では,対象物体以外の全体からもオプティカルフローが抽出されてしまいます.そこで,ロボットの移動量から画素の変化量を推定し,オプティカルフローの修正を試みました.こちらの動画では,上述したオプティカルフローの修正の有無による,移動ロボットの人物検出ならびに動作認識性能の差をご覧になれます.前半はオプティカルフローが修正されず,人物検出も動作認識もできていません.一方後半では,ロボットが移動しながら人物検出とその動作の認識に成功しています.

以上の研究は,いずれも4期生の新村君が3年間かけて一人で達成してくれた内容です.その後,オプティカルフローを用いた研究は10期生の菅田君の研究に引き継がれ,動作計画の研究に発展します.

移動ロボットのモデルベースの経路・動作計画(2015~2017年)

移動ロボットが自律的に移動するため,我々は,ロボットの経路および動作計画に注目しています.この研究では,人とロボットの共存をテーマに動的な環境をターゲットとし,ロボットが人と衝突することなく目的地に向け移動するための動作計画に関する技術開発を行っています.なお,ここでの動作計画とは,センサ情報を入力に,動作(速度や角速度)を出力するための数理モデルのことを指しており,これらは所謂数理モベルベースな手法に分類されます.

下の動画では,ロボットがA*アルゴリズムを実時間で実行することにより,壁に挟まれた人混み環境内にて経路を計画しながら移動する様子がご覧になれます.我々なら壁の外側を迂回します.そこで,この急がば回れ的な動作計画法を提案しました.

歩行者のような動的障害物を避けるための動作計画法として,従来VO(Velocity Obstacle)が知られています.しかしながら,遮蔽された障害物に対しては,センサで観測することができないため,回避の動作計画が困難となります.そこで,遮蔽を考慮できるよう,VOを改良した動作計画法も提案しています.

2017以降は,モデルベースの経路・動作計画法の研究から深層学習に基づいた動作計画の研究にシフトし,現在はこちらに注力しています.これは,前者が計測精度に依存するアプローチなのに対して,後者のアプローチでは,深層学習を通じて計測誤差を考慮した動作計画が可能であるためです.

移動ロボットによる知的な警備システム(2012~2024年)

自律移動ロボットに監視カメラを搭載した警備ロボットシステムの研究です.現状の警備ロボットは,基本,オペレータが設定した場所を監視することしかできません.これに対して我々の研究では,ロボットが訪問者や進入者の傾向を確率情報として特定し,それに基づいた警備に焦点をあてています.

左下の写真は,3台のロボットと警備環境(廊下)の地図を示しています.ロボットは集中管理システムの下,2D LiDARを用いて自律移動しながらKinect等のカメラにより進入者を発見することができます.各ロボットの持つ確率情報は無線通信によりホストコンピュータへ送信され,最適な警備ルートがホストコンピュータより各ロボットへ指令されます.さらに,ホストコンピュータが環境を各ロボットに独立した警備領域に分割し割り当てることで,警備中のロボット同士による衝突を避け,投入台数分の効率化にも成功しました.実際にロボットが警備を行う様子は,右下の動画でご覧ください.

2019年より,落とし物や不審物等の環境変化を検知するためのロボットビジョンに関する研究にも取り組んでいます.以下の動画は,7期生の齋藤陽都君による研究成果の発表動画です.同期の小林君同様,彼らの研究成果はロボット学会のフルペーパー論文に採択されました

その後,深層学習技術を用いたロボットに対する不審行動の検知や,人流に応じた警備領域の分割の研究に取り組みましたが,2024年度をもって一旦休止となっている研究テーマです.

葉緑体ロボット群のSwarm Intelligence(2014~2018年)

植物細胞の中には葉緑体があります.ウィキペディアには,「葉緑体とは,光合成を行う半自律性の細胞小器官」と書かれています.植物は,光合成により二酸化炭素から酸素を作り出すことができます.そして,葉緑体がその重要な役割を担っているのですそんな葉緑体の群れですが,顕微鏡でのぞいて見ると,光合成時に均整の取れた動きをしていることが分かります.光合成のため光に集まり,一方で影からは出ようとする動きをするのです.詳細については,本学バイオサイエンス教育研究センター児玉研究室が公開している葉緑体の集合反応をご覧ください.この葉緑体の運動のメカニズムをロボットの群行動(Swarm Intelligence)にも応用できないかと始めたのがこの研究です.

本学は工学と農学の連携(工農連携)に力を入れており,上述の児玉先生と共同で研究に取り組みました.そして,葉緑体群の相互作用のモデル化ならびに実機のロボットへの実装により,3台の葉緑体ロボットが互いの影から脱しながら光へと集合する動きを創発させることに成功しました.実際のロボットの挙動は,以下の動画でご覧になれます.

本葉緑体ロボットシステムを活用することで,床の掃引作業にも成功しました.

指のような機構の脚を有するロボットSHIKYAKU(2012~2018年)

平らな整地だけでなく,ボコボコした不整地でも単純な制御で移動できるロボットの機構を開発しました.「単純」と書いたのは,一般的な脚式や履帯式(クローラ型)でも不整地の移動は可能なのですが,その制御がかなり複雑なものになってしまうからです.

そこで,指の伸展・屈曲機構に着目しました.我々は,開発した脚のことを指脚(シキャク)と呼んでいます.造語です.この動画では,製作した2台のSHIKYAKUロボットによる歩行の様子がご覧になれます.SHIKYAKUロボットは,モータの正転・逆転の繰り返しという単純な制御のみで歩行することができます.また,各脚は1個のモータのみで動作します.

小型滑空ロボットの開発と自律操舵制御(2012~2016年)

無人飛行機UAV(Unmanned Aerial Vehicle)としては,ドローンが一般的ですが,本研究では,動力を持たず受動的に滑空するロボットの開発に取り組みました.この動画では,製作した機体および搭載されるマイコン・センサ,サーボモーター,これらに電力を供給するためのバッテリー等をご覧になれます.

動力がないため,小型・軽量化することが可能です.また,燃料も不要です.ただし,いかにして長時間・長距離を滑空できるかが課題となります.そのため,風や気流を利用しなくてはなりません.そこで,自身の姿勢から舵(操舵)を決定するための制御システムをファジー推論に基づき開発しました.動画の後半では,滑空シミュレーションを上面と側面から見た様子がご覧になれます.

本研究は,2016年度で一旦終了となりましたが,6自由度運動方程式等,航空機の制御系に関する知識はその後の無人航空機の自動操縦システムの研究に活かされました.

人間とロボットのインタラクション(相互作用)(2013~2015年)

これ以降の3テーマについては,1期生の牧君が4年次に一人で全て達成してくれた研究内容となっています!!

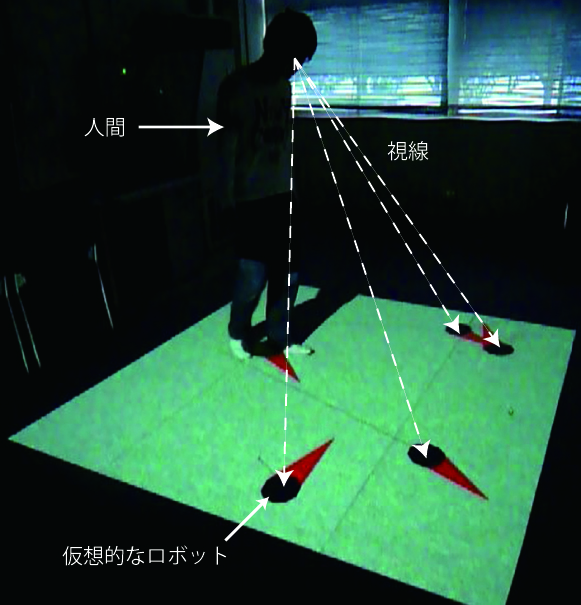

本研究では,シミュレーション空間の情報を床面へ投影することにより,疑似的な人間とロボットの仮想空間を構築しました.この空間では,人は目線に入るロボットの影響を受けながら移動し,ロボットも,人間に応じた動きをとることとなります.つまり,人間に対するロボットの制御だけでなく,ロボットによる人間の制御という,双方向の制御(相互作用)が実現するのです.そして,人間の位置,速度,移動方向といった物理的な情報に基づいたロボット群の安全で効率的な動作計画法を提案しました.

この他にも,ロボットの群れで人の動きを誘導するための隊列制御の研究に取り組んでいます.以上の研究成果は,その後,移動ロボットのモデルベースの経路・動作計画へと発展します.これらの研究は,必ずや人とロボットの共存に向けた技術的なブレークスルーを生み出すものと考えています.

人の動特性とロボットの混雑を考慮した人工ポテンシャル法(2012~2015年)

移動ロボットの動作計画として用いられている人工ポテンシャル法には,ポテンシャルの極小点における停留問題があります.さらに,ポテンシャルの大きさによって安全性と効率性がトレードオフとなることが問題になります.本研究では,これらの問題を解決しました.

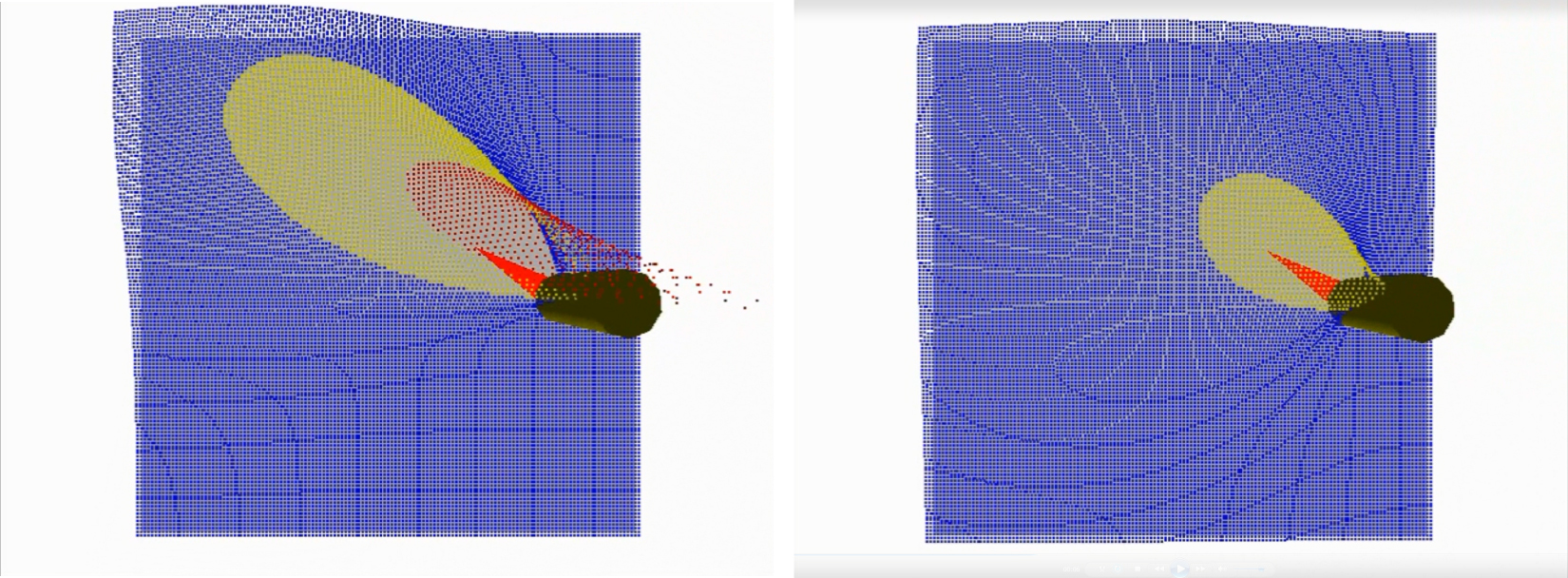

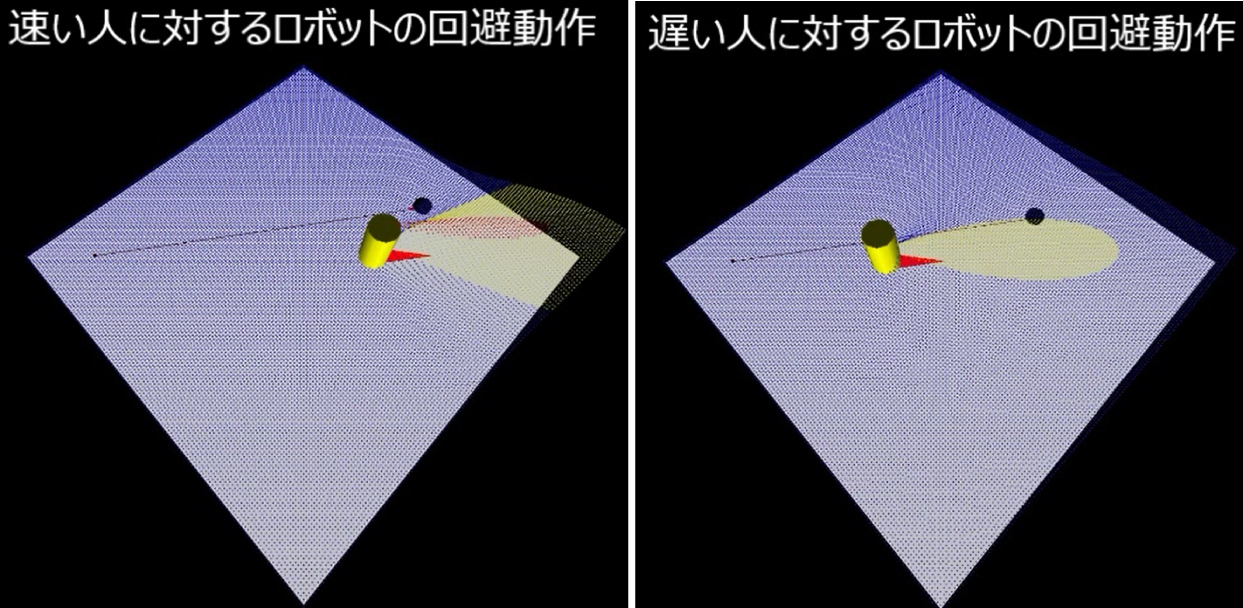

下の図では,人(黄色の円柱)と向かい合って移動するロボット(黒丸)が,互いに回避動作をとっている様子を示しています.人の進行方向に対して,速度に応じたポテンシャルが生成され,このポテンシャルの影響が及ぶ領域において,ロボットは斥力を受け人を回避します.そのため,速く動く人に対しては早めの回避動作を,遅く動く人に対しては近くで回避動作をとっていることが見てとれます.我々はこのポテンシャルのことを動特性ポテンシャルと名付けました.

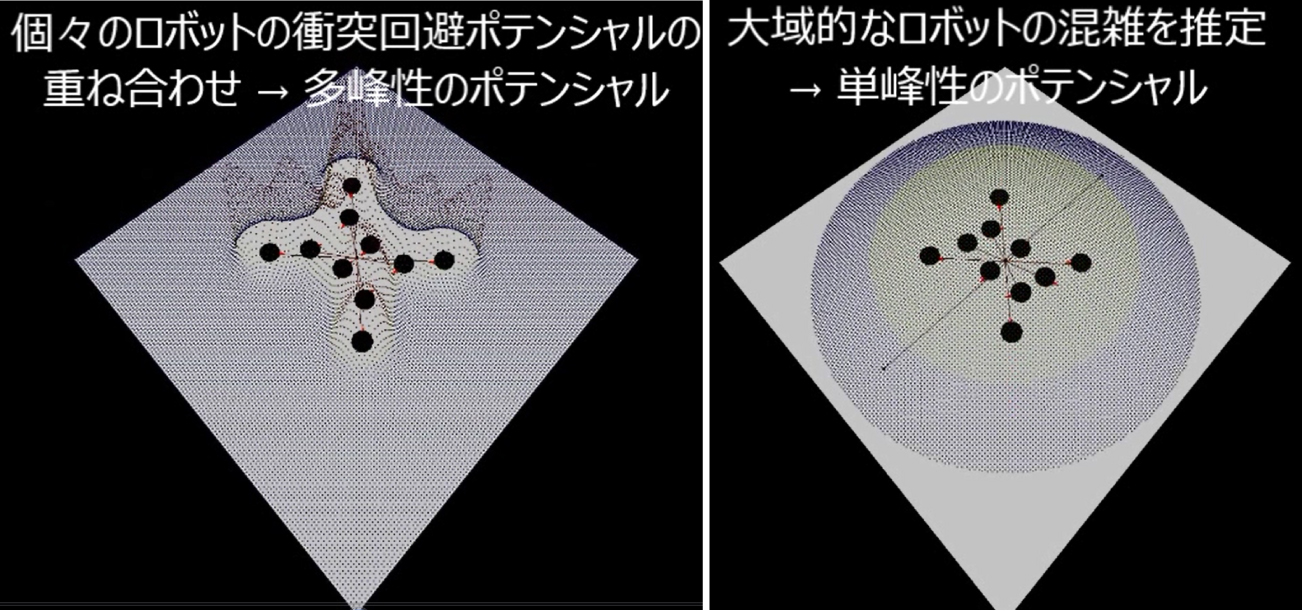

下の図は,複数のロボット群に対し,ロボット間での衝突を回避するために設けられたポテンシャルを示しています.左側では,単純に各ロボットのポテンシャルを重ね合わせただけであり,多峰性のポテンシャルが生成されています.斥力はポテンシャルの傾斜方向に向かってはたらくため,これではロボットが混雑し,渋滞が発生してしまいます.そこで,空間全体の密度を表現するための混雑緩和ポテンシャルを提案しました.右側では,これにより空間に単峰性のポテンシャルが生成されています.その結果,ロボット群全体で調和のとれた動作が実現されました.

以上,動特性ポテンシャルと混雑緩和ポテンシャルの組合せにより,安全で効率的なロボットの動作計画に成功しました.

実際の人の動きを考慮した動特性ポテンシャルの生成(2012~2015年)

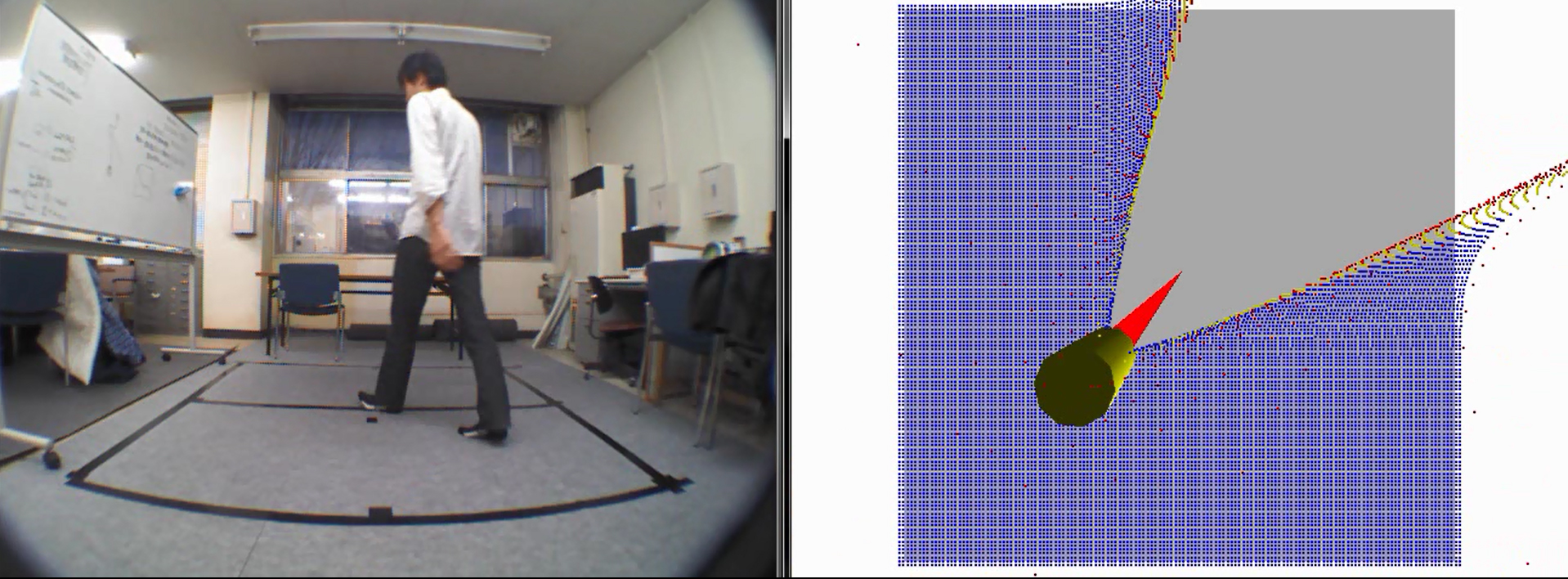

実環境へ動特性ポテンシャルを適用するためには,システム側が人間の動きを計測できる必要があります.そこで本研究では,計測システムを構築しました.下図では,人間の位置,速度,移動方向が計測され,そのデータから実際の人間に対するポテンシャルが生成されています.これにより,例えば真っ直ぐ歩く人には進行方向へ伸びるポテンシャル,蛇行して歩く人には周囲に広がるポテンシャルが生成され,人間の動きに応じたロボットの動作計画が可能となります.

下の図は,ジグザグ歩行した人間に対して,直進するものと仮定して生成された動特性ポテンシャル(左側)と,実際の動きに応じて生成された動特性ポテンシャル(右側)を示しています.同じ動きの人間に対して,右側では,周囲広範囲に渡りポテンシャルが生成されているのを見てとることができます.相手が真っ直ぐ歩いているならこちらも真っ直ぐ歩きますが,酔っ払いがフラフラと歩いている場合,距離をあけて歩きますよね.ロボットにも,この人間と同じような動きをさせることが可能なのです.